Tabela de Conteúdo

ToggleIntrodução

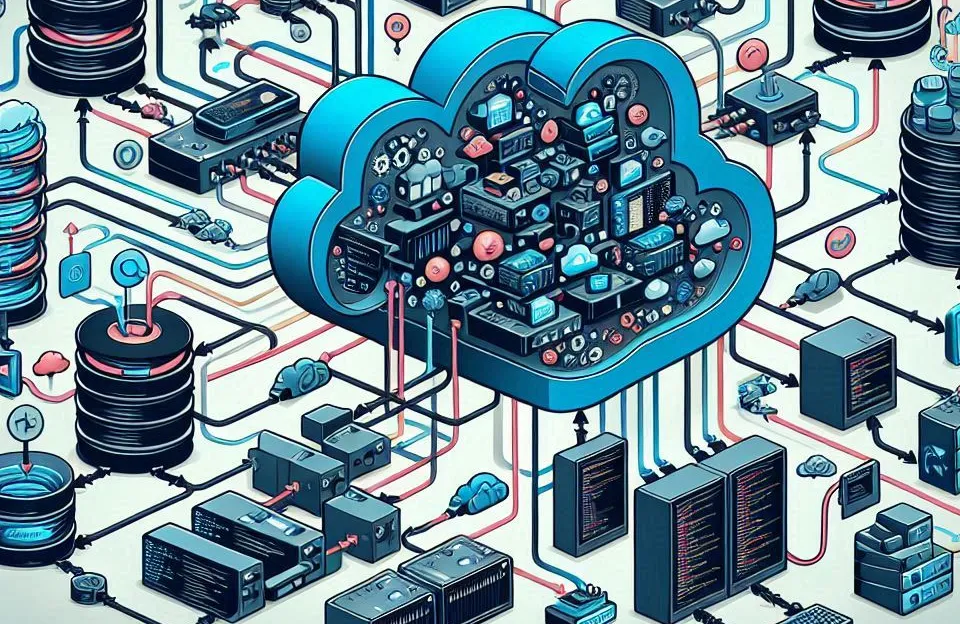

Primeiramente, construa um sistema de streaming distribuído com Python e Kafka pode parecer um desafio, mas com o conhecimento certo, é totalmente possível. Neste artigo, vamos te guiar passo a passo para criar uma solução robusta utilizando apache kafka e Python. Além disso, se você está buscando uma maneira eficiente de processar grandes volumes de dados em tempo real, essa combinação é perfeita para você.

Apache kafka é uma plataforma de streaming distribuída que facilita o gerenciamento e processamento de fluxos de dados em tempo real. Em outras palavras, ele permite que você lide com enormes quantidades de dados de forma eficiente e escalável. Conjuntamente com Python, uma das linguagens de programação mais populares do mundo, você pode criar um sistema poderoso de forma relativamente simples.

O Que é Apache Kafka?

A princípio, entender o que é apache kafka é fundamental para qualquer projeto de streaming. O kafka é uma plataforma open-source de stream processing, projetada para lidar com fluxos de dados em tempo real. Ou seja, ele permite que você processe, armazene e analise grandes volumes de dados de maneira distribuída e escalável. Bem como, o apache é amplamente utilizado em grandes empresas para lidar com dados massivos, como logs de servidores, transações financeiras, entre outros.

Por Que Usar Apache Kafka Com Python?

A utilização de apache kafka juntamente com Python traz diversas vantagens. Antes de mais nada, Python é conhecido por sua simplicidade e vasta gama de bibliotecas, o que facilita a integração com o apache. Além disso, kafka python permite que você desenvolva soluções rápidas e eficientes para processar dados em tempo real.

Configurando o Ambiente

Instalando o Apache Kafka

Antes de mais nada, é necessário instalar o kafka. Primeiramente, você precisa baixar a última versão do Kafka no site oficial. Após o download, extraia os arquivos e configure as variáveis de ambiente para facilitar o uso.

Configurando o Python

Agora, vamos configurar o ambiente Python. Conjuntamente com o apache, você precisará instalar algumas bibliotecas específicas. A mais importante delas é o kafka-python, que permitirá a comunicação entre seu código Python e o apache kafka.

pip install kafka-python

bashCopiar código

Criando um Tópico no Kafka

Antes de mais nada, para começar a transmitir dados, você precisa criar um tópico no kafka. O tópico é onde os dados serão armazenados temporariamente até serem consumidos pelos consumidores.

bin/kafka-topics.sh --create --topic meu-topico --bootstrap-server localhost:9092 --partitions 1 --replication-factor 1

Desenvolvendo o Produtor de Dados em Python

O Que é um Produtor no Kafka?

No apache kafka, um produtor é responsável por enviar mensagens para um ou mais tópicos. Em outras palavras, ele é a origem dos dados no sistema de streaming.

Escrevendo o Código do Produtor

A princípio, o código para o produtor em Python é bem simples. Utilizando a biblioteca kafka-python, você pode enviar dados para o apache kafka de maneira eficaz.

from kafka import KafkaProducer

producer = KafkaProducer(bootstrap_servers='localhost:9092')

producer.send('meu-topico', b'Minha mensagem')

producer.flush()

Testando o Produtor

Depois de configurar o produtor, é essencial testá-lo para garantir que está enviando as mensagens corretamente para o apache kafka. Ao mesmo tempo, você pode usar o console do Kafka para verificar se as mensagens estão sendo recebidas no tópico.

Desenvolvendo o Consumidor de Dados em Python

O Que é um Consumidor no Kafka?

Um consumidor no apache kafka é responsável por ler as mensagens dos tópicos e processá-las. Em outras palavras, ele é o destino dos dados no sistema de streaming.

Escrevendo o Código do Consumidor

Agora, vamos criar o código do consumidor em Python. Da mesma forma que o produtor, o código do consumidor utiliza a biblioteca kafka-python.

from kafka import KafkaConsumer

consumer = KafkaConsumer('meu-topico', bootstrap_servers='localhost:9092')

for message in consumer:

print(f'Received message: {message.value}')

Testando o Consumidor

Ao mesmo tempo, é importante testar o consumidor para garantir que ele está recebendo e processando as mensagens corretamente. Do mesmo modo, use o console do Kafka para verificar se as mensagens estão sendo consumidas.

Lidando Com Falhas e Garantindo a Escalabilidade

Resiliência no Apache Kafka

Conjuntamente com as vantagens do apache kafka, vem a necessidade de garantir que seu sistema seja resiliente a falhas. Todavia, o apache kafka oferece diversas configurações que ajudam a garantir a durabilidade e a disponibilidade dos dados, mesmo em caso de falhas nos servidores.

Escalabilidade e Particionamento

Além disso, um dos grandes benefícios do apache kafka é sua capacidade de escalar horizontalmente. Isso significa que você pode adicionar mais partições aos tópicos para distribuir a carga de trabalho entre diferentes consumidores.

Segurança no Sistema de Streaming

Autenticação e Autorização

Apesar disso, a segurança é uma preocupação fundamental em qualquer sistema distribuído. No apache kafka, você pode configurar mecanismos de autenticação e autorização para garantir que apenas usuários autorizados possam enviar e consumir dados.

Criptografia de Dados

Além de proteger o acesso, é importante garantir que os dados transmitidos estejam seguros. Conjuntamente com o suporte para SSL/TLS, o apache kafka permite criptografar os dados em trânsito, protegendo-os contra interceptação.

Monitorando e Mantendo o Sistema

Ferramentas de Monitoramento

Nesse sentido, para garantir que seu sistema de streaming distribuído funcione de maneira eficiente, é crucial monitorar sua performance. Ferramentas como Prometheus e Grafana são amplamente utilizadas para monitorar o apache kafka e seus componentes.

Manutenção Preventiva

Por exemplo, manter o sistema atualizado e realizar backups regulares são práticas essenciais para evitar problemas futuros. Ao mesmo tempo, é importante revisar as configurações do Kafka periodicamente para garantir que estejam otimizadas.

Casos de Uso para Apache Kafka com Python

Streaming de Dados de Sensores IoT

Primeiramente, o apache kafka é amplamente utilizado em aplicações de Internet das Coisas (IoT). Sensores enviam grandes volumes de dados em tempo real, e o apache kafka junto com Python pode processar esses dados de forma eficiente.

Processamento de Logs em Tempo Real

Conjuntamente com a coleta de dados de sensores, outra aplicação popular é o processamento de logs de servidores. Apache kafka python permite que você processe e analise logs em tempo real, facilitando a detecção de anomalias.

Análise de Redes Sociais

Por fim, outra aplicação interessante é a análise de dados de redes sociais. Apache kafka pode ser utilizado para processar grandes volumes de dados de redes sociais, como tweets, e conjuntamente com Python, você pode criar análises em tempo real.

Conclusão

Portanto, construa um sistema de streaming distribuído com Python e Kafka é uma excelente maneira de lidar com grandes volumes de dados em tempo real. Afinal, a combinação de apache kafka com Python oferece uma solução poderosa, escalável e flexível para diversas aplicações. Assim, com as orientações fornecidas neste artigo, você está pronto para iniciar seu próprio projeto de streaming distribuído. Dessa forma, invista tempo em entender as particularidades do Kafka e as possibilidades que Python oferece para criar um sistema robusto. Por fim, lembre-se de monitorar e manter seu sistema regularmente para garantir que ele continue funcionando de maneira eficiente.

Perguntas Frequentes

A principal vantagem é a combinação da simplicidade de Python com a robustez e escalabilidade do kafka, permitindo o processamento de grandes volumes de dados em tempo real.

Você pode configurar SSL/TLS no kafka para criptografar os dados em trânsito e utilizar mecanismos de autenticação e autorização para proteger o acesso.

Sim, o kafka é altamente escalável, permitindo a adição de partições para distribuir a carga de trabalho entre consumidores e aumentar a capacidade do sistema.